WordPress, robots.txt и левые ссылки в выдаче

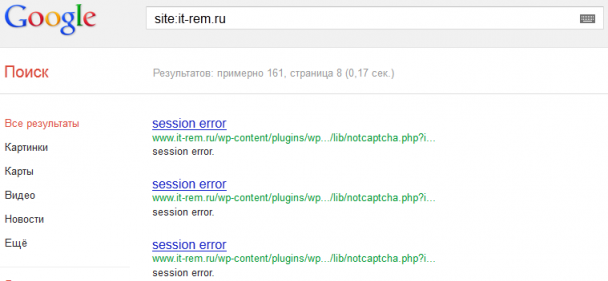

Сегодня решил посмотреть все ли страницы этого блога индексируются. И заметил что в индексе гугла, было кроме нужных страниц еще куча страничек с именем: session error.. Что же это за зверь подумал я..

Разумеется, я увидел, что эти странички генерирует плагин wp-notcaptcha ( о проблемах с которым я кстати недавно писал: WordPress: admin-ajax.php сильно грузит сервер ). Пошел по указанной гуглом ссылке, там оказались картинки, которые генерирует этот плагин. Разумеется, юзерам, эта выдача будет абсолютно не нужна в серпе.

Серп - результаты поиска (от англ. SERP — Search Engine Results Page)

Тогда я решил заблокировать, их через robots.txt, а заодно и всякие другие адреса, по которым поисковикам ходить не нужно. В итоге у меня получился вот такой файлик:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 |

User-agent: YandexBlog Disallow: User-agent: * Allow: /wp-content/uploads/ Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /xmlrpc.php Disallow: /readme.html Disallow: /licence.txt Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/languages Disallow: /wp-content/plugins Disallow: /wp-content/themes Disallow: /wp-content/upgrade Disallow: /wp-content/w3tc Disallow: /wp-trackback Disallow: /wp-feed Disallow: /wp-comments Disallow: */trackback Disallow: */feed Disallow: */comments #Disallow: /tag #Disallow: /category #Disallow: /archive Disallow: */trackback/ Disallow: */feed/ Disallow: */comments/ Disallow: /?feed= Disallow: /?s= Host: www.it-rem.ru Sitemap: https://it-rem.phpdev.one/sitemap.xml |

Как Вы видите, первой строчкой идет поисковик YandexBlog, этот поисковик собирает только фиды, именно поэтому я ему разрешил все, чтобы не писать кучу правил. Так просто короче.

Ну, а всем остальным, запретил то, что им не важно. У меня есть сомнения по поводу страниц категорий, архивов и тэгов, поэтому я пока их закомментировал. Так сказать, подготовил на будущее, если это будет необходимо. Вот собственно и всё.

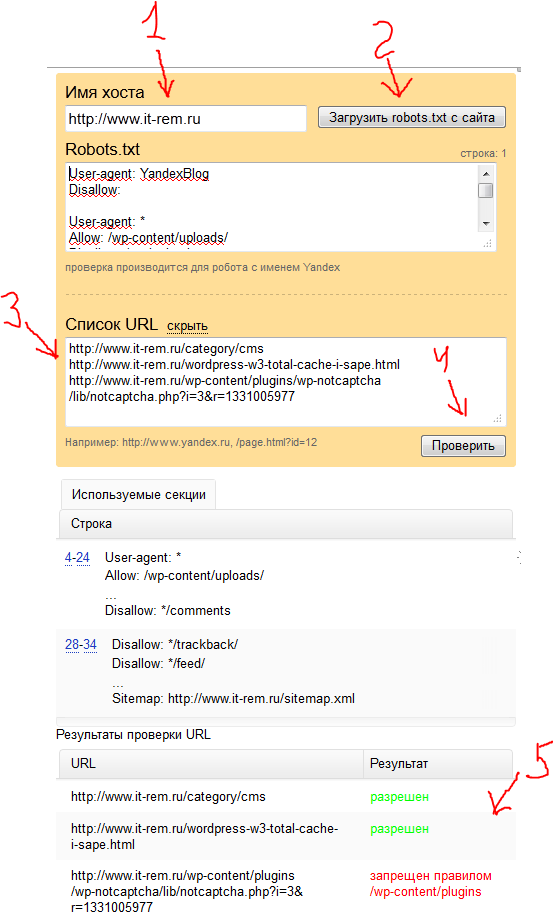

Дальше я этот текст, скопировал в файлик: https://it-rem.phpdev.one/robots.txt и все что мне осталось, это сделать проверку его корректной обработки. Для этого я воспользовался чекером от Янедкса: Я.Вебмастер - Анализ robots.txt (http://webmaster.yandex.ua/robots.xml#results)

Там все просто, указываете адрес файла, нажимаете [Загрузить], добавляете url страниц которые хотите проверить, и нажимаете кнопку [Проверить]. Результатом работы будет сообщение о том какие страницы открыты для индексации, а какие закрыты.

Author: | Rating: / | Tags:

Leave a Reply